Tuotamme tällä hetkellä noin 2,5 kvintiljoonaa (miljoonaa biljoonaa) tavua dataa maailmanlaajuisesti joka päivä. Vain neljässä päivässä luotujen tavujen kokonaismäärä on suunnilleen sama kuin koko maapallon hyönteispopulaatio. Suurin osa näistä tiedoista vastaanottaa kaikenmuotoisia ja -kokoisia yrityksiä. Heidän tulevaisuutensa yrityksinä riippuu siitä, kuinka he muuntavat kerätyt tiedot luotettavaksi bisnestiedoksi, jota käytetään ja kaupataan onnistuneesti.

"Yritysarvon saaminen kaikilta tiedoilta on ensiarvoisen tärkeää", kirjoitti David Stodder, TDWI:n business intelligence -tutkimusjohtaja, vuoden 2021 kolmannen neljänneksen Pulse Reportissa. "Ihmiset tarvitsevat keinoja tutkia, analysoida, visualisoida ja jakaa datatietoja helposti ja luovasti, jotta he voivat vastata muuttuviin olosuhteisiin ja tehdä tietoisia päätöksiä."

Kyky valjastaa, analysoida ja ansaita rahaa päivittäisen datan kiireessä yritysten kassaan on tekoälyllä – big datan loistavalla taajuuskorjaimella. Koneoppimismallit voivat tuottaa tuloksia, jotka vaikuttavat yrityksen toiminnan kaikkiin osa-alueisiin rahoituksesta tuotekehitykseen ja asiakkaiden ostotottumuksiin. Silti yritykset kamppailevat koneoppimisprojektien edistämisen kanssa pilottivaiheen jälkeen, mikä hidastaa tai sabotoi ponnistelujaan ottaa tekoälymalleja käyttöön oikea-aikaisesti.

"Tekoälyn käyttöönottojen aiheuttaman päänsäryn vuoksi organisaatiot pitävät kultamallin tuotantoon kuluvaa aikaa opportunistisena parannusalueena", raportoi TechTargetin osasto Enterprise Strategy Group (ESG). "Kun data muuttuu nykyaikaisessa ja dynaamisessa liiketoiminnassa, organisaatiot tuntevat yhä enemmän, ettei tekoälyn käyttöönottoon kuluu lähes kuukausi."

Tässä videossa Cognilytican Kathleen Walch ja Ron Schmelzer käsittelevät vastatuulia, joita yritykset kohtaavat koneoppimisprojektien piloteissa, jotka kaikki voivat johtaa kalliisiin viivästyksiin mallin käyttöönotossa. Kaikki alkaa kysymällä oikeita kysymyksiä liiketoiminnan näkyvyydestä ja sovelluksista, tiedon laadusta ja määrästä, infrastruktuurista ja toteutuksesta, henkilöstöstä ja asiantuntemuksesta sekä toimittaja- ja tuotevalikoimasta. Vastaukset näihin kysymyksiin ratkaisevat, onko koneoppimisprojekti käynnissä vai ei.

Transkriptio

Kathleen Walch: Hei kaikki, ja tervetuloa tähän webinaariin "Kuinka siirrät koneoppimisprojektisi pilotin ohi." Tämä on yleiskatsaus tekoälyprojektien menetelmiin. Puhumme siitä, miksi ylipäätään käyttää tekoälyä, ja sitten joitain sudenkuoppia välttää. Tämän esittelevät Cognilytican analyytikot Kathleen Walch ja Ron Schmelzer.

Joten, hieman Cognilyticasta, jos et ole tutustunut meihin: Cognilytica on tekoälyyn ja kognitiiviseen teknologiaan keskittyvä tutkimusneuvonta- ja koulutusyritys. Tuotamme markkinatutkimusta, neuvontaa ja ohjausta tekoälyyn, koneoppimiseen ja kognitiiviseen teknologiaan. Tuotamme myös suosittua AI Today -podcastia. Olemme tehneet sitä noin neljä vuotta, joten olet ehkä kuullut meidät siellä. Sivustollamme on myös infografiikkasarja, valkoinen paperi ja muuta suosittua sisältöä. Keskitymme tekoälyn omaksumiseen yrityksissä ja julkisella sektorilla, ja osallistumme myös kirjoittajiin sekä Forbesiin että TechTargetiin.

Ron Schmelzer: Joo. Joten toivottavasti olet lukenut paljon tekoälyä ja koneoppimista käsitteleviä artikkeleitamme. Ja nyt meidän tavoitteenamme on auttaa sinua, jos työskentelet koneoppimisprojektin parissa, pääsemään ohi vaikeuksista, joita saatat joutua tekemään koneoppimisprojektien toteuttamisessa. Joten siirrytään seuraavaan diaan täällä.

Ja mielestäni yksi suurimmista esteistä monille ihmisille, jotka yrittävät viedä koneoppimisprojektejaan eteenpäin, on varmistaa, että he ratkaisevat oikean ongelman. Usein yksi tekoälyn perusongelmista on se, että ihmiset yrittävät soveltaa tekoälyä ongelmaan, johon se ei todellakaan sovi kovin hyvin. Ja yksi asia, jota voimme tarkastella matkallamme, mihin tekoäly sopii todella, todella hyvin? Yksi asia, josta puhumme tutkimuksessamme, ovat nämä seitsemän tekoälymallia, koska tekoälyn ongelma on se, että se on hieman yleinen termi. Ja haaste on, kun kaksi eri ihmistä puhuu tekoälystä, he eivät ehkä puhu samasta asiasta.

Yleensä, menemättä yksityiskohtiin, meillä on nämä mallit. Sinulla voi olla tekoälyjärjestelmiä, jotka ovat hyviä luokittelemaan tai tunnistamaan järjestelmiä - tunnistusmallia - tai käyttämään luonnollisen kielen käsittelyä keskustelujärjestelmien tekemiseen. Hyödynnätkö big dataa ja löydätkö molemmat mallit siitä big datasta tai poikkeavuuksia big datassa, vai autatko sinua tekemään parempia ennusteita ennakoivan analytiikan avulla? Meillä voi olla myös koneoppimisjärjestelmiä, jotka voivat auttaa meitä tekemään asioita, joita ihmiset muuten tekisivät autonomisten järjestelmien kanssa. Tai ehkä löytää optimaalinen ratkaisu pulmaan, peliin tai vastaavaan tai johonkin skenaarioon, jota kutsutaan tavoitelähtöisiksi järjestelmiksi. Tai voisimme itse asiassa saada tekoälyn koneoppimisjärjestelmämme pureskelemaan valtavia määriä dataa auttaaksemme luomaan yksilön profiilin. Kaikille näille on yhteistä se, että käytämme tietoja oivallusten saamiseksi. Ja sen vuoksi emme kirjoita sääntöjä ja käytämme siis todennäköisyyttä, vaan tilastoja. Ja jos emme voi kirjoittaa sääntöä järjestelmälle, mutta tarvitsemme koneen tekemään jotain, se on hyvä merkki siitä, että tekoälykoneoppiminen saattaa olla hyvä ratkaisu siihen. Jos se on todennäköisyyttä, mitä koneoppimisjärjestelmät ovat, meidän pitäisi käyttää oppimismallia. Se on koneoppimista.

Walch: Aivan. Joten on tärkeää ymmärtää, milloin tekoälyä tulee käyttää, ja on myös tärkeää ymmärtää, mihin se ei sovellu. Joten jos sinulla on toistuva, deterministinen automaatiotehtävä, älä käytä tekoälyä ja koneoppimista. Jos sinulla on kaavaanalytiikka, mene eteenpäin ja tee se. Myös järjestelmät, jotka vaativat 100 % tarkkuutta. Koska se on todennäköisyyspohjaista eikä determinististä, et voi koskaan saada 100 % tarkkuutta – ja jos sitä tarvitset, tekoäly ja koneoppiminen eivät ole oikea työkalu tähän. Tilanteet, joissa harjoitustietoa on hyvin vähän – tiedätkö, aina on kysymys siitä, kuinka paljon harjoitusdataa todella tarvitsen? Ja sanomme, että se riippuu siitä, mitä mallia yrität tehdä. Mutta yleisesti ottaen, jos sinulla ei ole paljon harjoitusdataa – tiedäthän, se on hyvin, hyvin vähän – ei todennäköisesti sovi tekoälylle ja kognitiivisille teknologioille. Myös tilanteet, joissa henkilön palkkaaminen voi olla helpompaa, halvempaa ja nopeampaa. Tiedätkö, näiden järjestelmien rakentaminen vie aikaa, et voi vain tarttua siihen ja alkaa käyttää sitä. Joten jos kyseessä on pieni projekti tai jotain, jossa pelkkä ihmisen palkkaaminen on helpompaa, se saattaa olla parempi ratkaisu. Älä myöskään tee tekoälyä vain tehdäksesi tekoälyä, koska se on siisti tekijä tai muotisana, ihmiset puhuvat siitä. Varmista, että se todella tarjoaa arvoa ja että sitä käytetään oikeassa tilanteessa. Joten kuten Ron aiemmin mainitsi, jos se on todennäköistä, käytä tekoälyä; jos se on deterministinen, käytä sen sijaan ohjelmointilähestymistapaa.

Schmelzer: Aivan. Joten nyt tiedän, että monet teistä saattavat kiistellä joidenkin näistä kohdista ja sanoa: "Odota hetki, emmekö yritä rakentaa tekoälyjärjestelmiä, jotka voivat käyttää pientä määrää harjoitusdataa, ehkä ei harjoitusdataa, visiota mitä kutsutaan nollakuvausoppimiseksi – tai jopa pilvipohjaisten järjestelmien käyttö, joilla on valtava malli, jota voimme ehkä kouluttaa uudelleen tai laajentaa käyttämällä siirtooppimista, joitain näistä pilvinäköjutuista? Vastaus on, kyllä, se on totta; vaikka jotkin näistä kohdista ovat alkaneet häipyä, mikä tarkoittaa, että laajennamme tekoälyn ja koneoppimisen soveltamismahdollisuuksia tilanteisiin, joissa harjoitustiedot ovat alhaiset, tai tilanteisiin, joissa meillä on ehkä ihminen suorittamassa tehtävää ja ehkä Tekoälyjärjestelmän kustannukset ja monimutkaisuus ovat nyt vain vähentyneet huomattavasti.

Ainoa syy, miksi mainitsemme sen, on se, että joskus nämä ongelmat ovat tekijä. Ja niistä tulee tekijä, kun tarkastellaan tekoälyn go/no-go -päätöstä, jota Intel ja muut ovat itse asiassa popularisoineet ja joka on osa menetelmää tekoälyn koneoppimisprojektien tekemiseen hyvin. Siinä tapauksessa sinun tulee kysyä itseltäsi nämä kysymykset – ja nämä kysymykset auttavat sinua tunnistamaan, ovatko tekoälyn koneoppimisprojektit edes mahdollisia, kun otetaan huomioon ongelmat, joita yrität ratkaista. Yksi, onko sinulla ongelman määritelmä, joka on edes selvä? Tiedätkö mitä ongelmaa yrität ratkaista? Jos ei, se on tavallaan suurin no-go, eikö niin? Onko organisaatiossasi ihmisiä, jotka ovat valmiita muuttamaan mitä tahansa he tekevät nyt? Jos vastaus on ei, ei ole mitään järkeä rakentaa konseptitodistusta, etkä voi edes tehdä pilotista totta. Ja sitten tietysti kysymys on, onko tällä edes mitään vaikutusta? Nämä ovat yritysten näkyvyyttä koskevia kysymyksiä.

Sitten meillä on nämä datakysymykset, jotka palaavat joihinkin kohtiin, joista Kathleen puhui aiemmin. Onko meillä edes tietoa, joka mittaa sitä, mistä välitämme? Vaikka se on pieni määrä, mittaako se edes sitä, mitä haluamme? Onko meillä tarpeeksi? No, tiedäthän, vaikka haluammekin tehdä nolla- ja ehkä muutaman otoksen oppimista, se ei ole mahdollista kaikissa skenaarioissa. Se saattaa olla mahdollista tilanteissa, joissa meillä on suuri esiopetettu malli, kuten tietokonenäkö, mutta se ei ehkä ole mahdollista ennakoivan analytiikan ja kuvioiden ja poikkeavuuksien osalta, joissa pieni -- et halua havaita kuviota, kun on vain viisi tai kuusi esimerkkiä tästä mallista. Kaikki riippuu mallista, jonka yrität ratkaista. Lopuksi meillä on tietysti tietojen laatuongelmia. Tiedätkö, roskat sisään on roskat ulos. Näin on varmasti koneoppimisen kanssa. Meillä on siis näitä ongelmia. Nämä ovat kaikki tietoongelmia.

Ja sitten toteutuspuolella kysymys on, voimmeko edes rakentaa haluamaamme tekniikkaa? Onko meillä tarvitsemamme teknologiainfrastruktuuri? Onko meillä haluamamme koneoppimisen kehityspino? Voimmeko jopa tehdä sen vaaditussa ajassa, jos rakennamme tämän mallin? Yksi ongelma on, että harjoittelu voi viedä tonnin aikaa, onko meillä? Entä mallin suoritusaika? Onko se hyvin hidasta? Nämä ovat kysymyksiä, jotka meidän on kysyttävä.

Ja tietysti tämä viimeinen kohta on, voimmeko käyttää mallia siellä, missä haluamme käyttää mallia? Onko mallia mahdollista käyttää, jos joudumme käyttämään sitä esimerkiksi reunalaitteessa tai pilvessä tai paikallisessa ympäristössä? Voimmeko edes tehdä niin? Jos vastaus yhteenkään näistä kysymyksistä on ei, se itse asiassa tekee projektistasi erittäin vaikean tai melkein mahdoton. Jos kaikki vastaukset näihin kysymyksiin ovat kyllä, voit kuvitella ne olevan kuin liikennevalopankki: Jos kaikki valot ovat vihreitä, projektimme voi edetä. Tiedäthän, se ei ratkaise kaikkia ongelmia, mutta se kertoo meille, kuinka voimme viedä projektiamme eteenpäin. Ja se on tavallaan avain tähän haasteeseen.

Walch: Ja se on todella tärkeää varmistaa, että oikea tiimi on paikallaan ja että oikeat roolit ovat mukana ja hyödynnetään myös projektissa. Joten sanomme aina, että kysymme: "Onko oikea AI-tiimi paikallaan?" Ja siellä on muutama eri alue, joihin voit keskittyä. Joten, liiketoiminnan puoli, tiedätkö, haluatko, että liiketoiminta-alue on käytettävissä? Liiketoiminnan analyytikot, ratkaisuarkkitehdit, datatieteilijät – usein datatieteilijät kuuluvat tähän liiketoiminta-alueeseen. Joten tiedätkö, onko sinulla oikeat roolit ja taidot siellä? Sitten itse datatiede – tiedätkö, onko tiimissäsi datatieteilijä? Onko sinulla verkkotunnusasiantuntija? Ja sitten puhuimme tietoongelmista ja tietojen laatuongelmista. Onko sinulla siis tarvittaessa ulkopuolisia merkintöjä tai avustajia, jotta saat tietosi - varsinkin ohjatussa oppimisessa, joka vaatii hyvää, puhdasta ja hyvin merkittyä dataa. Onko teillä merkintäratkaisuja käytössä? Puhumme myös tietotekniikan roolista. Onko sinulla tässä roolissa tietosuunnittelija, järjestelmäsuunnittelija, datatiimi ja myös pilvitiimi, jota käytät tässä projektissa ja tässä tiimissä. Ja sitten operaatioon. Joten tämä on silloin, kun haluat todella käyttää mallia tuotannossa. Saatat tarvita sovelluskehittäjiä, järjestelmä- ja pilvijärjestelmänvalvojia. Joten nämä ovat kaikki erilaisia rooleja, joita vaaditaan, jotta AI-projektitiimisi menestyy. Ja sinun täytyy puhua tästä ja sanoa, tiedätkö, tarvitsenko jokaisen roolin? Onko minulla tehtäviä? Ja tiedätkö, onko minulla näitä yleensä, jotta voin käyttää niitä tarvittaessa?

Schmelzer: Joo, ja mielestäni haaste tässä on se, että saatat olla tai olla organisaationa pieni yritys. Saatat olla vain kourallinen ihmisiä organisaatiossasi tai saatat olla erittäin suuri organisaatio. Ja saatat ajatella tätä "Voi luoja, minun täytyy palkata kaikki nämä ihmiset." Ja vastaus on, no, sinun ei välttämättä tarvitse palkata näitä yksilöinä. Niiden on vain oltava rooleina, ja jos sinulla ei ole niitä rooleina organisaatiossa, pilottiprojektivaiheen ohittaminen tekee siitä paljon haastavamman, mistä tässä webinaarissa on kyse.

Kyllä, nyt on yrityksiä, jotka rakentavat työkaluja, jotka ikään kuin demokratisoivat datatieteitä antaakseen sen useamman ihmisen käsiin. On työkaluja, jotka auttavat tietojen suunnittelussa ja tekevät siitä paljon realistisemman tehtävän pienelle ihmismäärälle. Ja myös operatiivisuuden puolella tapahtuu asioita tässä kehittyvässä MLOps- ja ML-hallinnan, ML-hallinnon tilassa. Ja, mutta mielestäni pointti on, että sinun on varmistettava, että tämä käsitellään jollakin tavalla. Sitä käsitellään joko henkilön, roolin tai työkalun avulla. Jos sitä ei käsitellä millään noista asioista, ja sinulla on joukko ihmisiä, jotka haluavat saada asioita tapahtumaan, mutta hyvin harvat ihmiset voivat saada ne tapahtumaan, huomaat törmääväsi tähän tiesulkuun.

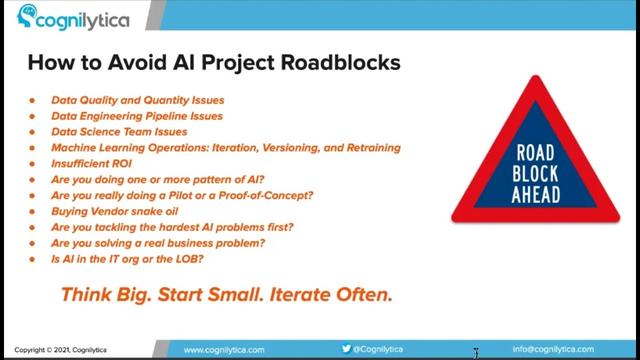

Joten osa tapaa välttää näitä tiesulkuja on tietysti kuin iso mantra - joka on "ajattele isosti, aloita pienestä ja toista usein". Mutta se liittyy pohjimmiltaan jokaiseen näistä AI-projektin haasteista, eikö niin? Ja voimme tavallaan käydä ne läpi. Ja olemme itse asiassa puhuneet joistakin niistä koko tämän webinaarin ajan – osa siitä on se, että jos sinulla on tietojen laatuongelmia ja datan määräongelmia, se on yksi mahdollinen este, ja sinun on selvitettävä: "Onko minun täytyykö ratkaista se kaikki kerralla? Vai voinko ratkaista vähän?" Se on jälleen, käytä "ajattele isosti, aloita pienestä ja toista usein" jokaiseen näistä luodeista. Ja ehkä voit aloittaa pienemmästä ongelmasta, joka vaatii pienempiä tietoja ja joka vaatii pienemmän määrän vaiheita, joita voit käyttää tietojen laatuongelmien ratkaisemiseen.

Walch: Aivan. Mukana on myös datatekniikan putkilinja- ja datatieteiden tiimiongelmia. Tiedätkö, puhuimme siitä, onko sinulla oikeat roolit? Ja jos et, niin tiedätkö, mieti kuinka saat sen. Tiedätkö, onko minulla muuta ratkaisua? Voinko palkata jonkun tähän rooliin? Voinko kouluttaa jonkun tähän rooliin? Ja jos vastaus on ei, se voi olla ongelma, joka voi olla tiesulku, joka sinulla on.

Schmelzer: Sama asia toiminnan kanssa, voimme ajatella asioita, joita tarvitsemme toiminnan kanssa. Miten aion versioida mallini? Kuinka aion iteroida malliani? Olenko rakentanut uudelleenkoulutusputken? Jos vastaus on ei, voinko toistaa sen sijaan, että ottaisin asian uudelleen puheeksi ja pureskelisin enemmän kuin pystyn pureskelemaan? Aloita yhdestä pienestä mallista; versio kyseisestä mallista; selvittää, kuinka tämä yksi malli, pieni malli, koulutetaan uudelleen; siirry sitten kahteen malliin tai suurempaan malliin. Tiedätkö, me voimme tehdä sen niin. Näin puutumme tiesulkuun. Sama asia sijoitetun pääoman tuottoprosentin kanssa – jos he sanovat: "Katso, minä en aio sijoittaa X miljoonaa dollaria tähän valtavaan ratkaisuun, josta minulla ei ole aavistustakaan ROI:sta. Voinko aloittaa. pieni? Voinko aloittaa pienemmällä projektilla pienemmällä ROI:lla ja iteroida parempaan ratkaisuun?" Sama juttu kuvioiden kanssa. Ehkä yritän, tiedätkö, keittää valtameren täällä ja tehdä kolme tai neljä tai viisi tekoälymallia kerralla – keskusteluntunnistusjärjestelmä, joka tekee ennakoivaa analytiikkaa sekä kuvioiden ja poikkeavuuksien havaitsemista itsenäisesti. Se voi olla hyvin, hyvin vaikea tehtävä. Voinko siis jakaa tämän projektin pienempiin vaiheisiin ja ehkä vain käsitellä keskusteluosuutta, vain tunnistusosuutta tai jotain muuta, ja sitten rakentaa sitä ajan myötä?

Luulen, että seuraava huolenaihe on se, että pilotin ja konseptin todisteen välillä on ero, eikö niin? Joskus niitä käytetään vaihtokelpoisina, mutta ei pitäisi. Todiste konseptista on, voinko vain kokeilla tätä tekniikkaa? Voinko edes tehdä sitä, mitä haluan tehdä? Tiedätkö, onko se niin, tiedätkö, onko minulla erityisiä taitoja? Tiedätkö, kokeilen tätä asiaa, voinko rakentaa niin sanotun leluprojektin tavoin vain nähdäkseni toimiiko se? Kun taas pilotin oletetaan olevan todellinen ongelma todellisessa ympäristössä, jossa on todellista dataa ja todellisia ongelmia. Ja luulen, että jos voit ratkaista nämä ongelmat -- voisimme taas aloittaa, ajatella isosti, aloittaa pienestä ja toistaa usein -- pienellä pilotilla, josta on todella hyötyä, ei jollain tavalla, joka on ei ole edes hyötyä. Eikö?

Walch: Aivan. Toinen asia, jonka olemme nähneet, on, että älä osta käärmeöljyä. Joidenkin näistä yrityksistä on siis paljon markkinointia ja jännitystä, ja joitain työkaluja ja tarjouksia, joita yritykset sanovat voivansa tarjota. Yritä välttää niitä, niitä sudenkuoppia. Koska se on tiesulku. Tiedätkö, jos yritys sanoo, että he voivat tehdä viisi, 10, 15 eri asiaa, mutta he eivät todellakaan voi, varmista, että ymmärrät sen. Lisäksi, ratkaisetko vaikeimmat tekoälyongelmat ensin? Tiedätkö, Ron sanoo - ja Cognilyticassa sanomme jatkuvasti - ajattele isosti. Ajattele siis noita vaikeita ongelmia, mutta aloita sitten pienestä ja toista usein. Jos puutut vaikeimpiin tekoälyongelmiin ensin, sen pitäisi tulla hyvin vähän yllätyksenä, että se tulee olemaan uskomattoman vaikea projekti ja todennäköisesti epäonnistuu. Jos aloitat pienestä ja jatkat iterointia, sinulla on paljon paremmat mahdollisuudet menestyä ja että projekti jatkuu eteenpäin. Lisäksi, ratkaisetko todellisen yritysongelman? Tiedätkö, tämä liittyy myös ROI-kysymykseen. Ratkaisetko todellista todellista yritysongelmaa vai rakennatko vain sitä pientä leluprojektia, josta Ron puhui? Ja sitten, tarjoaako se todellista sijoitetun pääoman tuottoprosenttia, joka on mitattavissa ja jolla on vaikutusta yritykseen?

Schmelzer: Joo, ja lopuksi, yksi toinen haaste, jonka saatat kohdata, jos osut pilottisulkuun, on se, missä tekoälyprojektia edes ajetaan? Toimiiko se IT-organisaation sisällä, joten sitä pidetään teknologia-asiana? Vai kuuluuko se toimialaan, jota käsitellään liiketoimintana? Näkökulmamme on tietysti, että tekoälytuotteet ovat muuttavia ja niiden pitäisi olla osa liiketoimintaa. Se ei ole IT-asia, vaikka siinä on teknologiakomponentti. Mutta aivan kuten et pyydä IT-organisaatiota kokoamaan Excel-laskentataulukoita ja -kaavioita yrityksellesi – se on yleensä osa liiketoiminta-aluetta, toimintoja, myyntiä, markkinointia, rahoitusta, toimintaa, mitä tahansa – sama asia tekoälyn kanssa. Tekoäly ei ole tekniikan funktio; se on liiketoimintaroolin funktio, ja siksi yrityksen tulisi olla vastuussa siitä ja sen tulee omistaa se.

Joten yksi asioista, joista puhumme paljon Cognilyticassa, on menetelmä, jolla voidaan tehdä tekoälyn koneoppimisprojekteja menestyksekkäämmin. Sitä kutsutaan nimellä CPMAI – kognitiivinen projektinhallinta tekoälylle, jos haluat tietää, mitä se tarkoittaa – ja se perustuu vuosikymmeniä vanhaan CRISP DM -nimiseen metodologiaan, joka alun perin keskittyi vain tietovarastoon ja tiedonhallintaan, tiedon louhintaprojekteihin. , joka on CRISP DM:n DM-osa. Ja se on pohjimmiltaan iteratiivinen metodologia, jolla aloitetaan liiketoiminnan ymmärtämisestä, mutta sitten käydään läpi nämä muut tiedon ymmärtämisen vaiheet: tietojen valmistelu, mallintaminen, mallin arviointi ja lopuksi mallin operaatio. Ja mitä CPMAI tekee, se lisää tekoälykohtaiset vaatimukset mallien kehittämisestä ja mallien arvioinnista. Ja katso, CRISP DM ei oikeastaan puhu mallin käyttöönotosta. Eli täysin uusi asia. Ja toinen asia, jonka CPMAI tekee, on se, että se tuo mukanaan ketterän menetelmän, joka ei todellakaan ollut kovin suosittu, kun CRISP DM ilmestyi ensimmäisen kerran. Ja tämä on hyväksytty menetelmä, eli voimmeko tehdä kahden viikon sprinttejä tekoälyprojekteissa, joissa voimme todella saavuttaa jotain todella hyödyllistä? Varsinainen koneoppimisprojekti lyhyessä sprintissä? Vastaus on tietysti, että voit, ja siitä CPMAI-metodologiassa on kyse. Kyse on menestyksen saavuttamisesta tekemällä sen, minkä Agile on osoittanut – eli ajattele isosti, aloita pienestä ja toista usein. Ja siitä tässä menetelmässä on kyse.

Walch: Aivan. Joten kiitos teille kaikille, jotka liittyitte tähän esitykseen. Ja jos sinulla on kysyttävää, voit aina ottaa meihin yhteyttä Cognilyticaan. Tietomme ovat alla.